“الديب فيك” يطارد مشاهير العالم.. مقاطع فيديو مزيفة للابتزاز والتشهير

تحقيق: أنيسة علي

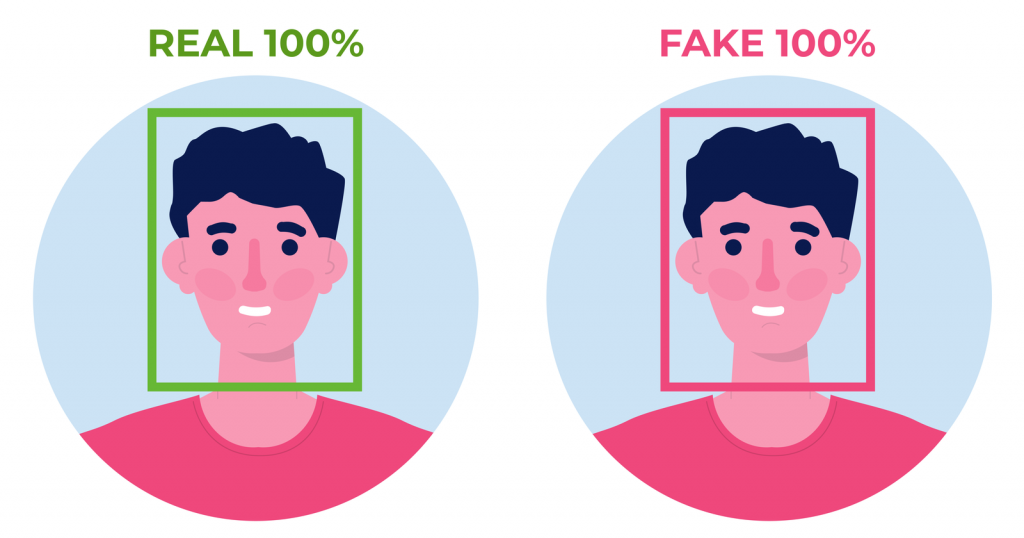

الديب فيك أو التزييف العميق، واحدة من أخطر التقنيات التي جلبها الذكاء الاصطناعي، حيث يتم استخدامها في تزييف مقاطع الفيديو بصورة يصعب على البشر تمييزها والتفرقة بين ما هو حقيقي وبين ما هو زائف، ويهدد الديب فيك بإشعال صراعات سياسية بين الدول فضلا عن تشويه سمعة المشاهير والمؤثرين العالميين، ومع التطور المذهل في هذه التقنية فإن الأمور ستزداد سواء مع استغلالها في الابتزاز والاحتيال والقرصنة.. في سطور التحقيق التالي قررنا أن ندق ناقوس الخطر للتنبيه بخطور الديك فيك؟ وما الذي يحمله المستقبل لهذا السلاح المدمر.

تعتمد هذه التقنية على ما يعرف بـ”التعلُّم العميق” وهو عبارة عن طريقة من طرق الذكاء الاصطناعي المتقدمة، والتي تستخدم عدة طبقات من خوارزميات التعلُّم الآلي من أجل استخلاص مزايا وملامح دقيقة عالية المستوى من أي محتوى خام. فيمكن لهذه التقنية استخراج بيانات دقيقة من بيانات غير منظمة، مثل الوجه البشري، فمثلًا يمكن للذكاء الاصطناعي أن يجمع بيانات عن كيف يتحرك جسمك وشكل خطواتك. ويمكن بعد ذلك معالجة البيانات من أجل إنشاء مقاطع فيديو زائفة لك. ويزداد إتقان الصور والفيديوهات المزيفة مع تحسن تلك التقنيات، وهذا يزيد من خطورة تقنية الديب فيك وشدة تهديدها. إضافةً إلى هذا، يمكن “للشبكات المولِّدة” التي تتولى ابتكار هذه المقاطع أن تزيِّف بيانات أخرى بخلاف الصور ومقاطع الفيديو، بل إن نفس تقنيات التعلُّم الآلي للديب فيك والتركيب يمكن استخدامها في تزييف الأصوات أيضا.

وتعمل هذه التقنية باستبدال صورة وجه شخص بوجه شخص آخر مستهدف، أو استبدال صوت شخص بصوت شخص آخر مستهدف، لتبدو مقاطع الوسائط المرئية أو السمعيّة المزيفة حقيقيّة بصورة كبيرة، ويتطور مستقبل الديب فيك باستمرار، فمنذ عامين فقط كان من السهل للغاية معرفة مقاطع الفيديو الزائفة من الجودة الرديئة للحركة أو من بعض الملامح لكن الآن من الصعب التمييز بين المزيف والحقيقي. أما الإصدارات الأحدث من مقاطع الفيديو الزائفة، فقد تطورت واستفادت من التقدم التكنولوجي.

ضحايا الديب فيك

ويقول الدكتور محمود فرج، الخبير في مجال أمن المعلومات والذكاء الاصطناعي، إن تقنية الديب فيك تعتمد على استخدام صورة شخص ما لإنتاج فيديو مزيف ويبدو للمشاهد للوهلة الأولى وكأنه فيديو حقيقي، وهنا تكمن خطورة الذكاء الاصطناعي في أنني أعطيه أي صور أو ملفات أو فيديوهات ثم يقوم بإنتاج منتج مزيف، مثل قصة فتاة المنصورة نيرة أشرف، رحمها الله، فقد استخدم بعض الهواة أدوات وتطبيقات الديب فيك وأنتجوا لها فيديوهات وصورا غير أخلاقية، أيضا تم إنتاج فيديو للرئيس الأمريكي جو بايدن، حيث قام شخص بتزييف فيديو يهاجم فيه دولة ما، مما تسبب في خلق أضرار وصراعات وخلافات بين أمريكا وبعض الدول الأخرى وخاصة روسيا.

وأضاف فرج أن هذه التقنية يترتب عليها أضرار شخصية للشخص نفسه أو أضرار إستراتيجية على مستوى الدول، كما يتم استهداف الشخصيات العامة ومشاهير وشخصيات دبلوماسية وأصحاب شركات كبيرة ورجال أعمال ومسئولين حكوميين في هذه الفيديوهات المزيفة، ويتم أيضًا استخدام هذه التقنية في الابتزاز والتشهير وافتعال الفضائح. لكن على الجانب الآخر، يتم استخدام هذه التقنية أحيانا في بعض الأعمال الفنية، فمثلا أصبح بالإمكان إظهار أحد الممثلين الراحلين وكأنه حي يرزق، ويشارك في تمثيل بعض الأدوار في أحد الأعمال الفنية الحديثة أو المعاصرة.

قلق عالمي

أما وليد حجاج، الخبير في مجال أمن المعلومات، وعضو لجنة الثقافة الرقمية والبنية المعلوماتية بالمجلس الأعلى للثقافة، فيقول إن تقنية الديب فيك تسببت في إحداث حالة من القلق العالمي، مما دفع العديد من الحكومات لفرض رقابة صارمة على هذه التطبيقات ومنعها من التداول والتحذير بشأن إنتاج مقاطع فيديو تخص شخصيات عامة أو سياسية. ويطلق على هذه التقنية اسم الخداع العميق، حيث إنه يمكن لشخص أن يقلد صوت أحد أو يركب نصوصاً معينة على صور أشخاص فيخدع أي أحد يسمعه أو يركب كلاماً على صوت أي شخص مشهور، وقد تجاوزت هذه التقنية كافة الخطوط الحمراء، حيث يتم استخدامها في اختراق الحسابات أو الخدمات البنكية التي تستخدم بصمة الصوت ككلمة سر، حيث أصبح في الإمكان أن يتم تزيف وتزوير كلمة السر، ويتم أخذ نماذج من صوت الشخص، ويتم تدريب الذكاء الاصطناعي عليه لكي ينتج نفس الصوت.

ويوجد تقريبًا أكثر من 15 ألف فيديو ديب فيك في الوقت الحالي! بعضها مصنوعة بهدف المرح فقط، بينما البعض الآخر يحاول التلاعب بآرائك وتغييرها. الآن قد يستغرق الأمر يومًا أو يومين لصنع فيديو ديب فيك، ويمكن أن يقل الوقت المطلوب بسرعة شديدة.

ومن بين طرق اكتشاف التزييف العميق، أنه بإمكان المختصين مراجعة محتوى مقاطع الفيديو لاكتشاف الأخطاء، وتطبيق تقنيات التحقق الموجودة، واستخدام الأساليب القائمة على الذكاء الاصطناعي لاكتشاف تقنية التزييف العميق. وقد استُعمِلت هذه التقنيّة في إنشاءِ مقاطع فيديو إباحيّة مزيفة لعددٍ من المشاهير كما استُخدمت في أحيان أخرى لخلق اخبار كاذبة ومُحاولة الخداع والانتقام.

وعندما تنظر لأي صورة في وقتنا الحالي يطرح عقلك بصورة تلقائية تساؤلا منطقيا، هل هذه الصورة حقيقية أم مزيفة؟ فكرة باتت أساسية عند الجميع نظراً للعدد المهول من الصور والمقاطع المزيفة التي أصبحت منتشرة في عالمنا. وعلى سبيل تم نشر مقطع ضمن مجموعة من المقاطع على تيك توك للممثل الأمريكي توم كروز. ولم يكن هو توم كروز في الواقع بل مقاطع تم تزييفها بتقنية التزييف العميق. حيث إن صاحب الحساب خرج منتحلاً شخصية توم كروز وبدأ في نشر عدد من المقاطع التي نالت تفاعلا ضخما من المتابعين، ولم يكتشف أي أحد أن هذه المقاطع مزيفة سوى عندما أعلن توم كروز أن هذا الحساب لا يتبع له، وأنه لم يتواجد على هذه المنصة ليكشف صاحب الحساب أنه ليس توم كروز وأن الحساب مزيف.

مخاطر مستقبلية

وفي ظل التقدم الكبير الذي تحققه هذه التقنية يصبح التنبؤ بالمستقبل أمراً مخيفاً وقدرة هذه الخوارزميات في تزييف مقاطع الفيديو قد يأخذ منحنى خطيرا خارج مجال الترفيه. حيث يصل التزييف الآن إلى السياسيين ورجال الاقتصاد وقد تندلع حروباً أو صراعات بين دول بسبب مقطع من هذه المقاطع في المستقبل، الذي تشهد فيه هذه التقنية تطورات مذهلة.